2026년 새해가 밝았습니다.

새해 복 많이 받으시고 희망과 행복이 가득한 새해를 맞 하시길 기원합니다.

https://youtu.be/MMYi3nDDxMI?si=MkcKiQHF9rC-21gw

[심층 연구 보고서] 감시의 전이: 동독 슈타지의 '체제 붕괴(Zersetzung)'에서 알고리즘 기반 '디지털 판옵티콘' 사회로의 진화

"알고리즘은 우리의 검색 기록과 위치를 낱낱이 볼 수 있지만, 결코 우리의 영혼까지 정의할 수는 없습니다."

서문: 보이지 않는 감시자의 탄생

인류의 역사는 권력과 감시의 끊임없는 줄다리기였습니다.

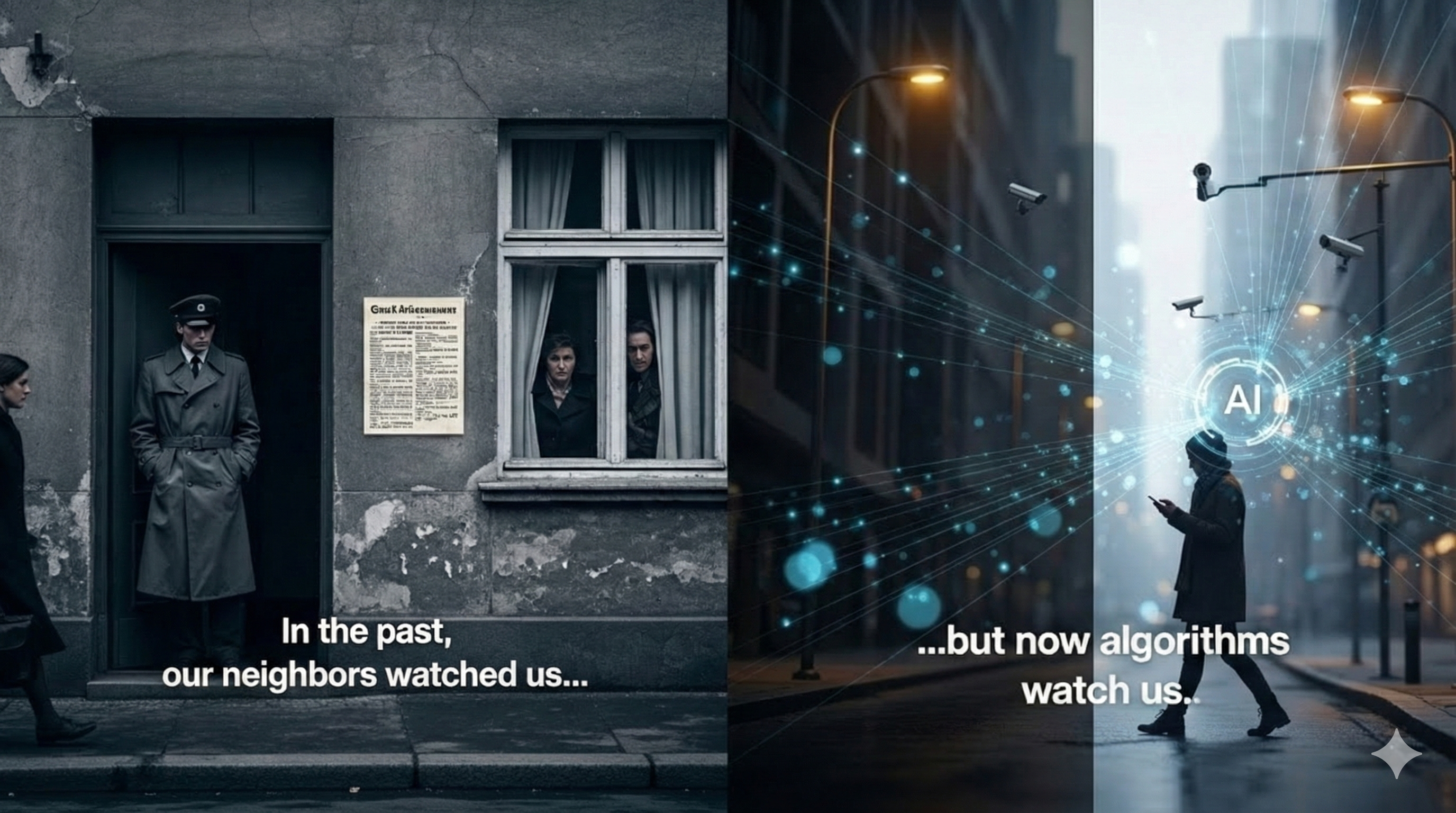

그러나 21세기에 접어들며 우리는 감시의 패러다임이 근본적으로 뒤바뀌는 거대한 전환점에 서 있습니다. 과거의 감시가 이웃의 시선, 도청 장치, 비밀경찰이라는 물리적이고 가시적인 공포에 의존했다면, 현대의 감시는 데이터, 알고리즘, 인공지능(AI)이라는 비가시적이고 효율적인 메커니즘으로 진화했습니다.

"과거엔 이웃이 우리를 감시했지만, 이젠 알고리즘이 우리를 감시합니다."

이 명제는 단순한 기술적 발전만을 의미하지 않습니다. 감시의 주체가 '불완전한 인간'에서 '오류를 모르는(것처럼 보이는) 시스템'으로 이동했음을 시사합니다. 또한 감시의 목적이 사후 적발과 처벌에서 사전 예측과 행동 수정으로 확장되었음을 의미합니다.

본 보고서는 20세기 가장 정교한 감시 국가였던 동독의 국가보안부(슈타지)가 자행한 심리적 와해 공작인 '체제 붕괴(Zersetzung)'를 역사적 거울로 삼아, 오늘날 AI 감시 사회가 제기하는 윤리적 위험성을 심층 분석합니다.

우리는 미셸 푸코의 '판옵티콘(Panopticon)'이 디지털 공간에서 어떻게 구현되고 있는지, 그리고 쇼샤나 주보프가 경고한 '감시 자본주의'가 우리의 자유 의지를 어떻게 침식하고 있는지 고찰할 것입니다.

나아가 한국 사회의 구체적인 사례를 통해 우리가 직면한 위험의 실체를 규명하고, EU의 AI 법(EU AI Act)과 프라이버시 강화 기술(PETs) 등 구체적인 해법을 모색함으로써, 기술 독재 시대를 대비하기 위한 우리 사회의 준비 과제를 제언하고자 합니다.

1장. 역사적 재조명: 동독 슈타지의 감시와 '체제 붕괴(Zersetzung)'

1.1 슈타지(Stasi): 인류 역사상 가장 촘촘한 감시망

독일민주공화국(GDR, 동독)의 국가보안부, 통칭 '슈타지(Stasi)'는 "모든 것을 알아야 한다(Wissen ist Macht)"는 모토 아래 자국민을 철저히 감시하고 통제했던 조직입니다. 1989년 베를린 장벽이 무너지기 직전까지 슈타지는 약 9만 1천 명의 정규 직원과 17만 4천 명에 달하는 '비공식 협조자(Inoffizielle Mitarbeiter, IM)'를 거느리고 있었습니다.1

1.1.1 감시 밀도와 비공식 협조자(IM) 네트워크

통계에 따르면 동독 인구 약 60명당 1명이 슈타지와 직간접적으로 연관되어 있었습니다. 이는 나치 독일의 게슈타포나 소련의 KGB보다 훨씬 높은 감시 밀도였습니다. 슈타지는 사회의 모든 층위에 침투해 있었습니다. 직장 동료, 학교 친구, 심지어 배우자가 정보를 제공하는 경우도 비일비재했습니다. 이러한 구조는 사회적 신뢰 자본을 근본적으로 파괴했습니다.1

이웃이 이웃을 감시하는 구조는 단순히 정보를 수집하는 것을 넘어, 시민들이 서로를 불신하게 만들고, 체제에 대한 저항 의지를 원천적으로 봉쇄하는 심리적 기제로 작동했습니다. 누군가 나를 지켜보고 있다는 막연한 공포는 실제 감시보다 더 강력한 통제 수단이었습니다.

1.2 영혼을 파괴하는 심리전: 체제 붕괴(Zersetzung)

1970년대 데탕트 분위기와 함께 동독이 국제적인 인권 감시를 받게 되자, 슈타지는 물리적 구금이나 고문 대신 더욱 은밀하고 파괴적인 방법을 고안해냈습니다. 1976년 슈타지 지침(Richtlinie 1/76)을 통해 공식화된 이 전술이 바로 '체제 붕괴(Zersetzung)'입니다. 이 용어는 화학적 분해나 부패를 의미하는데, 슈타지는 이를 '적대적 행위를 하는 개인이나 그룹을 파편화하고, 마비시키며, 고립시키는 것'으로 정의했습니다.2

1.2.1 체제 붕괴의 구체적 실행 전술

체제 붕괴의 목표는 대상자가 자신이 공격받고 있다는 사실조차 인지하지 못한 채 서서히 무너지게 만드는 것이었습니다. 현대적 관점에서 이는 국가 주도의 조직적인 '가스라이팅(Gaslighting)'이자 '스토킹'이었습니다.

| 전술 분류 | 구체적 실행 사례 | 심리적 효과 |

| 현실 조작 (Gaslighting) | 대상자가 부재중일 때 가구 위치를 미세하게 옮김, 특정 물건을 훔쳤다가 며칠 후 돌려놓음, 차의 타이어 공기압을 매일 조금씩 뺌 | 기억력과 정신 상태에 대한 자기 의심 유발, 편집증적 불안 증세 야기 3 |

| 사회적 고립 | 직장 내 승진 누락 유도, 동료들에게 대상자가 동성애자라거나 범죄자라는 헛소문 유포, 친구들을 협박해 관계 단절 유도 | 사회적 지지 기반 상실, 극도의 외로움과 무력감 조성 3 |

| 의료적 남용 | 협조자 의사를 통해 잘못된 진단 내리기, 필요 없는 약물 처방, 건강 염려증 유발 | 신체적 건강 악화 및 의료 시스템에 대한 불신 조장 |

| 사생활 침해 | 익명의 협박 전화, 주문하지 않은 물건(예: 관, 성인용품) 배달, 냄새 샘플(Geruchsproben) 채취 | 사생활이 완전히 발가벗겨졌다는 수치심과 공포감 극대화 |

1.2.2 장기적 후유증과 사회적 비용

독일 통일 후 수십 년이 지난 지금도 체제 붕괴의 피해자들은 심각한 정신적 외상을 겪고 있습니다. 연구에 따르면, 슈타지의 감시 밀도가 높았던 지역의 주민들은 현재까지도 타인에 대한 신뢰도가 낮으며, 이는 정치적 참여 저조와 경제적 성과 하락으로 이어지고 있습니다.5 "신뢰"라는 사회적 자본이 감시로 인해 훼손되었을 때, 그 회복에는 세대를 넘어서는 시간이 필요함을 보여주는 실증적 증거입니다.

2장. 감시의 진화: 아날로그에서 디지털 판옵티콘으로

2.1 양적 팽창: 슈타지의 꿈, NSA의 현실

슈타지는 모든 정보를 수집하고자 했으나, 기술적 한계로 인해 수천 킬로미터에 달하는 문서 보관소와 수만 명의 인력에 의존해야 했습니다. 그러나 디지털 시대의 감시 기관은 이러한 물리적 제약에서 완전히 해방되었습니다.

2013년 에드워드 스노든의 폭로로 드러난 미국 국가안보국(NSA)의 감시 역량은 슈타지를 어린아이 장난처럼 보이게 만듭니다. 연구에 따르면 NSA는 슈타지보다 약 10억 배 더 많은 데이터를 저장하고 처리할 수 있는 것으로 추정됩니다.7 슈타지가 편지 봉투를 증기로 뜯어 내용을 확인했다면, 현대의 감시 시스템은 전 세계의 이메일, 메신저, 통화 기록을 실시간으로 패킷 단위로 감청하고 분석합니다.

2.2 감시 자본주의: 감시의 상업화

현대 감시의 가장 큰 특징은 감시의 주체가 국가에서 시장(Market)으로 확장되었다는 점입니다. 하버드 경영대학원의 쇼샤나 주보프(Shoshana Zuboff) 교수는 이를 **'감시 자본주의(Surveillance Capitalism)'**라고 명명했습니다.8

·행동 잉여(Behavioral Surplus): 기업은 서비스 개선에 필요한 데이터보다 훨씬 더 많은 데이터를 수집합니다. 우리의 검색 기록, 위치 정보, 마우스 커서의 움직임, 심지어 목소리 톤까지 수집되어 '행동 잉여'로 축적됩니다.10

·도구적 권력(Instrumentarian Power): 이 데이터는 우리의 미래 행동을 예측하는 것을 넘어, 우리의 행동을 기업이 원하는 방향으로 유도(Nudge)하는 데 사용됩니다. 이는 전체주의 국가의 강압적 권력과는 다른, 부드럽지만 저항하기 힘든 새로운 형태의 권력입니다.10

2.3 감시의 편재성과 비가시성

과거 동독 시민들은 슈타지의 존재를 알고 두려워했습니다. 그러나 현대의 시민들은 스스로 감시 장치(스마트폰)를 구매하고, 자신의 가장 내밀한 정보를 소셜 미디어에 자발적으로 업로드합니다. 감시는 '서비스'와 '편의'라는 포장지 속에 숨겨져 보이지 않게(Invisible) 작동합니다. 우리는 알고리즘이 우리를 분석하고 있다는 사실을 잊은 채 살아가지만, 시스템은 단 한순간도 눈을 떼지 않습니다. 이는 벤담이 설계하고 푸코가 해석한 '판옵티콘'이 완벽하게 디지털로 구현된 상태, 즉 "디지털 판옵티콘"입니다.

3장. 현대 AI 감시 기술의 메커니즘과 위험성

"이웃의 눈"이 사라진 자리를 대신한 것은 고도로 발달된 AI 알고리즘입니다. 이들은 지치지도, 잠들지도 않으며 편견을 수학적 확신으로 가장합니다.

3.1 예측 치안(Predictive Policing): 편향의 자동화

영화 <마이너리티 리포트>에서 묘사된 범죄 예측 시스템은 이미 현실화되었습니다. 미국의 'PredPol(현 Geolitica)'이나 영국의 'NDAS'와 같은 시스템은 빅데이터를 분석하여 범죄 발생 가능성이 높은 지역을 예측하거나, 특정인의 재범 위험성을 평가합니다.12

3.1.1 더러운 데이터(Dirty Data)와 피드백 루프

문제는 AI가 학습하는 데이터 자체가 역사적 편견을 담고 있다는 점입니다.

·작동 원리: AI는 과거 경찰의 체포 기록과 신고 데이터를 학습합니다.

·편향의 강화: 과거 경찰이 흑인 거주지나 저소득층 지역을 집중적으로 순찰하여 경범죄 검거 실적을 올렸다면, AI는 이를 "그 지역이 고위험군"이라고 학습합니다.

·피드백 루프: AI의 예측에 따라 경찰은 다시 해당 지역에 더 많이 배치되고, 더 많은 검거가 이루어집니다. 이는 다시 데이터로 축적되어 AI의 편향된 예측을 강화합니다.14

이는 "알고리즘은 수학적이므로 중립적일 것"이라는 믿음을 배반합니다. AI는 인종차별과 계급 차별을 과학의 이름으로 정당화하는 도구가 되고 있습니다.

3.2 생체 인식의 진화: 얼굴을 넘어 걸음걸이까지

CCTV와 안면 인식 기술의 결합은 이미 보편화되었습니다. 그러나 기술은 여기서 멈추지 않고 신체의 움직임까지 식별하는 단계로 진입했습니다.

3.2.1 보행 분석(Gait Analysis) 기술

중국의 AI 기업 'Watrix'가 개발하여 상용화한 보행 분석 기술은 현대 감시 기술의 정점을 보여줍니다.

·식별 능력: 50미터 떨어진 거리에서도 사람의 걷는 모습(실루엣, 보폭, 리듬 등)을 분석하여 신원을 식별합니다.16

·회피 불가능성: 안면 인식은 마스크나 선글라스로 얼굴을 가리면 피할 수 있지만, 걸음걸이는 무의식적인 습관이므로 의도적으로 바꾸기 어렵습니다. 일부러 다리를 절거나 구부정하게 걸어도 AI는 신체 전체의 특징을 분석하여 속임수를 간파합니다.17

·활용: 이 기술은 범죄자 추적뿐만 아니라, 얼굴을 가린 시위 참가자를 식별하는 데 악용될 소지가 매우 큽니다.18

3.3 감정 인식 및 사회적 신용 평가

AI는 이제 인간의 내면을 읽으려 시도합니다. 미세 표정, 동공의 떨림, 목소리의 톤을 분석하여 개인의 감정 상태나 진실성을 판단하는 기술이 채용 면접이나 보안 검색에 도입되고 있습니다.

나아가 개인의 금융 기록, 온라인 활동, 사회적 관계망을 종합하여 '사회적 신용 점수(Social Score)'를 매기는 시도는 인간을 등급화하고 행동을 통제하려는 전체주의적 발상입니다. 이는 EU AI 법에서 "용납할 수 없는 위험"으로 규정하여 엄격히 금지하려는 대표적인 기술입니다.19

4장. 한국 사회의 감시 현황: 편리함과 통제 사이

한국은 세계 최고 수준의 ICT 인프라와 CCTV 밀도를 자랑하지만, 이는 역설적으로 가장 효율적인 감시 사회가 될 수 있는 잠재력을 의미합니다.

4.1 촘촘한 CCTV망과 스마트 시티

한국의 주요 도시들은 '스마트 시티'라는 이름 아래 방범, 교통, 민간 보안 CCTV를 통합 관제하고 있습니다. 지능형 선별 관제 시스템은 AI가 CCTV 영상을 실시간으로 분석하여 싸움, 배회, 쓰러짐 등의 이벤트를 감지합니다.21 이는 범죄 예방과 시민 안전에 기여하는 측면이 분명히 존재하지만, 도시 전체가 거대한 '오픈 에어 감옥'이 될 수 있다는 우려를 낳습니다.

4.2 공공 부문의 AI 도입과 인권 침해 논란

한국 정부는 AI 강국 도약을 목표로 공공 행정과 치안 분야에 AI를 적극 도입하고 있으나, 개인정보 보호와 인권에 대한 고려는 속도를 따라가지 못하고 있습니다.

4.2.1 법무부 출입국 AI 데이터 무단 사용 사건

2021년, 법무부가 인천공항 출입국 심사 과정에서 수집된 내외국인 1억 7천만 건의 안면 데이터를 당사자의 동의 없이 민간 AI 기업에 넘겨 인공지능 학습용 데이터로 사용한 사실이 드러났습니다.21

·문제점: 이는 국가가 보유한 민감한 생체 정보를 정보 주체의 동의 없이 민간의 이윤 추구나 기술 개발 목적으로 전용한 사례로, '목적 외 사용' 금지 원칙을 위반했다는 비판을 받았습니다.

·시민사회의 대응: 진보네트워크센터, 민변 등 시민단체들은 이를 "전례 없는 개인정보 자기결정권 침해"로 규정하고 공익 소송과 캠페인을 전개했습니다.21

4.2.2 실시간 원격 감시의 위험성

국가인권위원회는 2023년 의견 표명을 통해 공공장소에서의 불특정 다수를 대상으로 한 실시간 원격 얼굴 인식 시스템 도입이 헌법상 사생활의 비밀과 집회·결사의 자유를 침해할 우려가 크다고 경고했습니다. 특히 집회 참가자들을 채증하고 식별하는 데 이 기술이 사용될 경우, 시민들의 정당한 의사 표현이 위축되는 '냉각 효과(Chilling Effect)'가 발생할 것임을 지적했습니다.24

5장. 윤리적 연결고리: 슈타지와 AI의 교차점

슈타지의 아날로그 감시와 현대의 AI 감시는 기술적 수단에서 극단적인 차이를 보이지만, 그 본질적인 윤리적 문제는 놀라울 정도로 맞닿아 있습니다. 우리는 역사에서 무엇을 배워야 합니까?

5.1 자율성의 침해: 가스라이팅에서 넛지(Nudge)로

슈타지의 '체제 붕괴' 전술은 대상자의 현실 인식을 조작하고 심리를 파괴하여 자율성을 박탈하는 것이었습니다. 현대의 AI 알고리즘은 훨씬 세련된 방식으로 자율성을 침해합니다.

추천 알고리즘과 맞춤형 광고는 우리의 취향을 분석하여 우리가 원할 만한 것을 끊임없이 제시합니다. 이는 표면적으로는 선택의 편의를 제공하는 것처럼 보이지만, 실상은 기업이나 알고리즘이 설계한 선택지 안으로 우리의 행동을 유도(Nudge)하는 것입니다.8

"당신이 이것을 좋아할 것"이라는 알고리즘의 제안은 "당신은 이런 사람이다"라는 규정이 되어, 인간의 가변적인 정체성을 데이터 감옥 속에 가두는 결과를 낳습니다. 이는 디지털 시대의 '부드러운 가스라이팅'입니다.

5.2 사회적 신뢰의 붕괴

슈타지 감시가 남긴 가장 뼈아픈 유산은 '이웃에 대한 불신'이었습니다. 누가 정보원(IM)인지 알 수 없는 상황에서 사람들은 입을 닫고 관계를 단절했습니다.

오늘날의 디지털 감시 사회에서도 유사한 현상이 발생합니다. 모든 온라인 활동이 기록되고, 나의 검색 기록이 신용 평가나 채용에 영향을 미칠 수 있다는 불안감은 자기 검열을 일상화합니다. 미셸 푸코가 지적했듯, 감시받고 있다는 의식은 규율을 내면화하게 만듭니다. 사회적 신뢰는 '투명성'이 아니라 '프라이버시(서로 모르는 부분)'가 보장될 때 형성됩니다. 사생활이 없는 사회에서는 진정한 신뢰도 존재할 수 없습니다.5

5.3 책임의 실종: 블랙박스 문제

슈타지의 경우, 가해자(국가, 담당 장교, 정보원)가 명확했습니다. 그러나 AI 감시 사회에서는 차별이나 인권 침해가 발생했을 때 책임 소재가 불분명합니다.

·"알고리즘이 그랬다"는 변명: 채용 AI가 여성을 차별하거나, 예측 치안 시스템이 흑인을 과잉 단속할 때, 개발자와 운영자는 알고리즘의 복잡성(Black Box) 뒤에 숨습니다.

·설명 가능성(Explainability)의 부재: AI가 왜 그런 결정을 내렸는지 인간이 이해할 수 없다면, 부당한 대우를 받아도 이의를 제기할 수 없습니다. 이는 민주주의의 핵심 원칙인 '책임성(Accountability)'을 위협합니다.25

6장. 해법과 제언: 우리는 무엇을 준비해야 하는가?

기술의 발전은 거스를 수 없는 흐름입니다. 그러나 그 방향키를 잡는 것은 인간의 몫입니다.

우리는 슈타지의 악몽이 디지털로 재현되는 것을 막기 위해 다층적인 방어 체계를 구축해야 합니다.

6.1 법적 규제: '금지선(Red Line)'의 설정

모든 기술이 허용되어서는 안 됩니다. 인류는 생화학 무기를 금지했듯, 인간의 존엄성을 근본적으로 침해하는 AI 기술을 금지해야 합니다. 2024년 통과된 유럽연합의 AI 법(EU AI Act)은 중요한 참고 모델입니다.19

[표 1] EU AI Act의 위험 기반 접근 및 시사점

| 위험 등급 | 정의 | 해당 기술 및 규제 내용 | 한국 사회 적용 제언 |

| 금지된 AI (Prohibited) | 인권에 용납할 수 없는 위험 초래 | - 사회적 신용 평가 (Social Scoring) - 공공장소 실시간 원격 생체 인식 (테러 등 예외 제외) - 인터넷/CCTV 얼굴 이미지 무단 크롤링 - 취약계층 착취 및 잠재의식 조작 기술 |

한국도 '사회적 신용 평가' 및 무분별한 생체 정보 수집을 법적으로 명시하여 금지해야 함. |

| 고위험 AI (High Risk) | 건강, 안전, 기본권에 중대 영향 | - 채용, 신용 평가, 사법 판단 보조 시스템 - 이민 및 국경 통제 시스템 - 필수 공공 서비스 접근 평가 |

도입 전 적합성 평가 의무화, 데이터 품질 관리, 인간의 감독권 보장 필요. |

| 제한적 위험 (Limited Risk) | 투명성 의무가 필요한 AI | - 챗봇, 딥페이크, 감정 인식 시스템 | 사용자가 AI와 상호작용 중임을 알 수 있도록 고지 의무화. |

한국 사회는 아직 AI에 대한 기본법조차 부재한 상황입니다.

산업 진흥에 치우친 정책에서 벗어나, EU와 같이 '허용할 수 없는 기술'의 기준을 명확히 하는 입법이 시급합니다.

6.2 절차적 안전장치: 알고리즘 영향 평가 (AIA)

환경 영향 평가가 개발 사업의 부작용을 미리 거르듯, 공공 부문에 AI를 도입할 때는 **'알고리즘 영향 평가(Algorithmic Impact Assessment, AIA)'**를 의무화해야 합니다.25

·핵심 내용: AI 시스템 도입 전, 이것이 특정 집단에 차별을 야기하지 않는지, 프라이버시를 침해하지 않는지 평가하고, 그 결과를 시민들에게 공개해야 합니다.

·시민 참여: 평가 과정에 외부 전문가와 시민사회가 참여하여 '블랙박스' 내부를 들여다볼 수 있는 기회를 제공해야 합니다. 캐나다 정부는 이미 자동화된 의사결정 시스템에 대해 AIA를 의무적으로 시행하고 있으며, 이는 전 세계적인 모범 사례입니다.28

6.3 기술적 해법: 프라이버시 강화 기술 (PETs)

법만으로는 기술의 속도를 따라잡을 수 없습니다. 기술적 위협에는 기술적 방어로 맞서야 합니다. **프라이버시 강화 기술(Privacy Enhancing Technologies, PETs)**의 개발과 도입을 적극 지원해야 합니다.29

| 기술 명칭 | 원리 및 효과 | 활용 예시 |

| 동형 암호 (Homomorphic Encryption) | 데이터를 암호화한 상태 그대로 연산 수행. 정보 유출 원천 차단. | 의료 데이터 분석 시 환자 개인정보 노출 없이 질병 연구 가능. |

| 차분 프라이버시 (Differential Privacy) | 데이터에 통계적 잡음(Noise)을 섞어 개별 식별을 불가능하게 함. | 인구 센서스 통계, 스마트폰 사용 패턴 분석 등. |

| 연합 학습 (Federated Learning) | 데이터를 중앙 서버로 모으지 않고, 각 기기(On-device)에서 학습한 결과값만 전송. | 스마트폰 키보드 자동완성, 병원 간 환자 데이터 협력 연구. |

정부는 공공 데이터를 개방할 때 이러한 PETs 기술 적용을 의무화하여, 데이터 활용과 개인정보 보호라는 두 마리 토끼를 잡아야 합니다.

6.4 시민의 역할: 디지털 자기 방어와 연대

마지막으로, 깨어있는 시민의 힘이 필요합니다. 슈타지를 무너뜨린 것은 결국 동독 시민들의 촛불이었습니다. 디지털 시대의 저항은 '데이터 주권'을 되찾는 것에서 시작됩니다.

·디지털 위생(Digital Hygiene): 2단계 인증 사용, 불필요한 쿠키 삭제, 암호화 메신저(Signal 등) 사용 등 개인적 차원의 보안 수칙을 생활화하여 자신의 데이터가 무분별하게 수집되는 것을 막아야 합니다.31

·감시자에 대한 감시(Watching the Watchers): 진보네트워크센터와 같은 디지털 권리 단체와 연대하여 정부와 기업의 감시 행위를 모니터링하고, 투명성을 요구하는 목소리를 높여야 합니다.33

·거부할 권리 행사: 자신의 생체 정보가 무단으로 사용되는 것에 대해 명확히 거부 의사를 밝히고(Opt-out), 필요한 경우 집단 소송 등 법적 대응을 불사해야 합니다.

7장. 결론: 인간을 위한 기술, 인간에 의한 통제

우리는 지금 '편리한 감시 사회'와 '불편한 자유 사회'의 갈림길에 서 있습니다.

동독의 작가 위르겐 푹스(Jürgen Fuchs)는 슈타지의 심리적 테러를 "영혼에 대한 살인"이라고 불렀습니다.

21세기의 알고리즘은 우리의 영혼을 살해하려 들지는 않지만, 우리의 영혼을 데이터로 분해하고, 예측하고, 상업적으로 거래 가능한 상품으로 만들고 있습니다.

과거에는 감시자가 숨어 있고 우리가 드러나 있었다면, 이제는 감시 시스템 자체가 우리 삶의 인프라가 되어버렸습니다. 이것이 우리가 경계해야 할 '빅브라더'의 진짜 얼굴입니다.

우리는 무엇을 준비해야 합니까?

1.경계: "기술은 중립적"이라는 환상을 버리고, 기술 뒤에 숨은 자본과 권력의 의도를 꿰뚫어 보아야 합니다.

2.준비: EU AI 법과 같은 강력한 법적 통제 장치를 마련하고, 프라이버시 강화 기술을 표준화해야 합니다.

3.행동: 알고리즘의 결정에 맹목적으로 따르지 않고, 인간의 존엄성을 기준으로 기술을 심판할 수 있는 비판적 사고를 길러야 합니다.

"알고리즘은 우리를 볼 수 있지만, 우리를 정의할 수는 없습니다."

이것이 기술 전체주의에 맞서 우리가 지켜내야 할 마지막 인간성(Humanity)의 보루입니다.

감시의 역사가 우리에게 주는 교훈은 명확합니다. 감시받지 않는 권력은 반드시 부패하며, 자유는 거저 주어지는 것이 아니라 끊임없이 감시하고 싸워서 쟁취하는 것이라는 사실입니다.

www.youtube.com/@BrandonAIEthics

Brandon AI Ethics. All about AI Ethics

Brandon AI윤리 Solution Center(BAESC)Brandon AI 윤리솔루션센터 기술은 빠르게 진화하지만, 우리는 그 속도를 따라가기보다 의미를 지켜갑니다. Brandon Ethics는 인공지능 시대의 윤리, 책임, 그리고 신뢰를

www.youtube.com

From Stasi's Zersetzung to Algorithmic Digital Panopticon: The Evolution of Surveillance

Executive Summary

This comprehensive report explores the paradigm shift in surveillance from the human-centric methods of East Germany's Stasi to the data-driven, algorithmic surveillance of the 21st century. While the Stasi utilized physical intimidation and psychological decomposition (Zersetzung) to control dissidents, modern society faces a "Digital Panopticon" powered by AI, Big Data, and biometrics. This report argues that surveillance has evolved from "neighbors watching neighbors" to "algorithms watching everyone," necessitating urgent ethical, legal, and technical interventions.

Historical Context: The Stasi's Legacy

The report details the operations of the Ministry for State Security (Stasi), highlighting its reliance on Inoffizielle Mitarbeiter (IM), where 1 in 60 citizens acted as informants. Special attention is given to Zersetzung (Directive 1/76), a psychological warfare tactic designed to "decompose" individuals through gaslighting, social isolation, and reputational destruction without physical imprisonment. The long-term effects of this surveillance are still visible today in the form of reduced social trust and economic performance in former East German regions.

The Modern Surveillance Landscape

Comparing the Stasi to modern entities, the report notes that the NSA and Big Tech companies possess data capabilities billions of times greater than the Stasi. Through the lens of Surveillance Capitalism (Shoshana Zuboff), the report analyzes how "Behavioral Surplus" is harvested to predict and modify human behavior (Nudging), creating a form of "Instrumentarian Power" that is softer but more pervasive than totalitarian coercion.

Mechanisms of Algorithmic Control

Key technologies driving this shift include:

·Predictive Policing: Systems like PredPol (Geolitica) which often automate racial and class bias through "dirty data" feedback loops.

·Gait Analysis: Advanced biometrics (e.g., Watrix) that identify individuals by their walk from 50 meters away, making anonymity in public spaces nearly impossible.

·Social Scoring: The evaluation of citizens' trustworthiness based on data, banned under the EU AI Act as an "unacceptable risk."

The South Korean Context

South Korea serves as a critical case study due to its high CCTV density and advanced digital infrastructure. The report highlights the controversy surrounding the Ministry of Justice's misuse of 170 million facial images for AI training without consent, and the Jinbonet report's critique of the lack of governance in public sector AI adoption. The National Human Rights Commission's warnings against real-time remote surveillance further underscore the tension between "Smart City" convenience and civil liberties.

Ethical Implications & Solutions

The report identifies core ethical issues: Loss of Autonomy (digital gaslighting), Erosion of Trust (chilling effect), and Lack of Accountability (black box algorithms).

To combat these, the report recommends:

1.Legal Action: Adopting legislation modeled after the EU AI Act to ban specific high-risk practices (e.g., social scoring, real-time biometric surveillance).

2.Procedural Safeguards: Mandating Algorithmic Impact Assessments (AIA) for all public sector AI deployments, following the Canadian model.

3.Technical Defense: Investing in Privacy Enhancing Technologies (PETs) like Homomorphic Encryption and Differential Privacy to protect data utility while preserving anonymity.

4.Civic Engagement: Promoting digital hygiene and supporting civil society organizations that monitor state surveillance.

Conclusion

The report concludes that while we cannot turn back the clock on technology, we must establish strict "Red Lines" to prevent the rise of a digital Big Brother. We must remember the lesson of the Stasi: power without oversight inevitably leads to corruption and the dehumanization of citizens.

참고 자료

1. “Zersetzung” Strategies and Utilisation of Psychological Warfare on Individuals and Groups Part One - Mario Bekes, “Zersetzung” Strategies and Utilisation of Psychological Warfare on Individuals and Groups Part One - Mario Bekes

2. Psychofolgen bis heute: "Zersetzungs"-Opfer der DDR ..., Psychofolgen bis heute: "Zersetzungs"-Opfer der DDR-Geheimpolizei | Stasi | bpb.de

3. STASI's Zersetzung & Modern Psychological Warfare - Mario Bekes, STASI’s Zersetzung & Modern Psychological Warfare

4. How to Recognize 5 Core Tactics of Gaslighting - Psychology Today, How to Recognize 5 Core Tactics of Gaslighting | Psychology Today

5. Long-Term Costs of Government Surveillance: Insights from Stasi Spying in East Germany | Journal of the European Economic Association | Oxford Academic, Long-Term Costs of Government Surveillance: Insights from Stasi Spying in East Germany | Journal of the European Economic Association | Oxford Academic

6. Press Release: Stasi Spying Victims Have Social and Economic Disadvantages | ZEW,, Press Release: Stasi Spying Victims Have Social and Economic Disadvantages | ZEW

7. Normalizing surveillance in daily life - Global Voices Advox,Normalizing surveillance in daily life · Global Voices Advox

8. Surveillance capitalism - Wikipedia, Surveillance capitalism - Wikipedia

9. Harvard professor says surveillance capitalism is undermining democracy, Harvard professor says surveillance capitalism is undermining democracy

10. Book Review - The Age of Surveillance Capitalism: The Fight for a Human Future at the New Frontier of Power - American University, Book Review - The Age of Surveillance Capitalism: The Fight for a Human Future at the New Frontier of Power

11. Book Review: The Age of Surveillance Capitalism: The Fight for a Human Future at the New Frontier of Power by Shoshana Zuboff - LSE Blogs,Book Review: The Age of Surveillance Capitalism: The Fight for a Human Future at the New Frontier of Power by Shoshana Zuboff

12. WRITTEN EVIDENCE SUBMITTED BY BIG BROTHER WATCH (RAI0036) Submission to the Joint Committee on Human Rights, WRITTEN EVIDENCE SUBMITTED BY BIG BROTHER WATCH (RAI0036) Submission to the Joint Committee on Human Rights

13. Algorithms in Policing: An Investigative Packet - Yale Law School, Algorithms in Policing: An Investigative Packet

14. HRDAG – Human Rights Data Analysis Group | How Predictive Policing Reinforces Bias, HRDAG – Human Rights Data Analysis Group | How Predictive Policing Reinforces Bias

15. Predictive Policing Explained | Brennan Center for Justice, Predictive Policing Explained | Brennan Center for Justice

16. New Surveillance Tool: Gait Recognition - Security Today, New Surveillance Tool: Gait Recognition -- Security Today

17. Chinese 'gait recognition' tech IDs people by how they walk - AP News, Chinese 'gait recognition' tech IDs people by how they walk | AP News

18. The West, China, and AI surveillance - Atlantic Council, The West, China, and AI surveillance - Atlantic Council

19. Article 5: Prohibited AI Practices | EU Artificial Intelligence Act, Article 5: Prohibited AI Practices | EU Artificial Intelligence Act

20. Emerging trends in gait recognition based on deep learning: a survey - PMC - NIH, 12월 30, 2025에 액세스, https://pmc.ncbi.nlm.nih.gov/articles/PMC11323174/

21. South Korea Faces Human Rights Concerns Over Expanding Public Sector Use of AI, South Korea Faces Human Rights Concerns Over Expanding Public Sector Use of AI

22. AI-powered CCTVs Enhance crime prevention in South Korea - Times Of AI, AI-powered CCTVs Enhance crime prevention in South Korea

23. “A human rights disaster”: S. Korean civic groups demand government halt creation of AI facial ID and tracking system - Hankyoreh, “A human rights disaster”: S. Korean civic groups demand government halt creation of AI facial ID and tracking system

24. NHRCK Emphasizes the Importance of Proactively Addressing Human Rights Risks Posed by Facial Recognition Technologies < Press Releases < Main Activities - 국가인권위원회, http://www.humanrights.go.kr/eng/board/read?boardManagementNo=7003&boardNo=7608785&page=1&searchCategory=&searchType=&searchWord=&menuLevel=2&menuNo=114

25. algorithmic impact assessments: - a practical framework for public agency accountability - AI Now Institute, algorithmic impact assessments: - a practical framework for public agency accountability

26. The EU AI Act's invisible clause: What everyone missed - ID-Pal, The EU AI Act’s invisible clause: What everyone missed - ID-Pal

27. Algorithmic impact assessment: user guide - Ada Lovelace Institute, Algorithmic impact assessment: user guide | Ada Lovelace Institute

28. Algorithmic Impact Assessment - OECD STIP Compass,Algorithmic Impact Assessment | STIP Compass

29. What are privacy-enhancing technologies? - Decentriq, What are privacy-enhancing technologies?

30. Keeping Your Privacy Enhancing Technology (PET) Promises | Federal Trade Commission,Keeping Your Privacy Enhancing Technology (PET) Promises | Federal Trade Commission

31. Face Off: Law Enforcement Use of Face Recognition Technology, Face Off: Law Enforcement Use of Face Recognition Technology | Electronic Frontier Foundation

32. PII Compliance Checklist | 2025 Requirements & Best Practices - Sentra, PII Compliance Checklist | 2025 Requirements & Best Practices

33. Korea, Republic of | Global Information Society Watch, Korea, Republic of | Global Information Society Watch

#AI_Ethics #Surveillance_Society #Stasi #Zersetzung #Digital_Panopticon #Predictive_Policing #Facial_Recognition #Gait_Analysis #Algorithmic_Bias #EU_AI_Act #Privacy_Enhancing_Technologies #Digital_Human_Rights #Data_Privacy #South_Korea_AI_Policy #Jinbonet #Algorithmic_Accountability #Civic_Resistance #History_of_Surveillance #Shoshana_Zuboff #Surveillance_Capitalism #Big_Brother #Digital_Self_Defense

'닥터 브랜든 모드 진료실 > AI윤리 심층 진단' 카테고리의 다른 글

| 인공지능 상용화 3년 명과 암: Sovereign AI, K자 성장, 그리고 2%의 경고 (0) | 2026.01.23 |

|---|---|

| 2026년 한국 인공지능 기본법의 심층 분석 및 EU AI Act와의 비교법적 고찰: 규제 공백의 역설과 글로벌 표준의 압력 (0) | 2026.01.16 |

| 2025년 동지(冬至)와 애동지의 민속학적 고찰: 역사적 유래, 국제적 비교 및 현대적 계승 방안에 대한 심층 보고서 (0) | 2025.12.22 |

| 2025 대한민국 데이터 안보 위기: 왜 기업들은 털리고도 당당한가? (쿠팡, SKT, 롯데카드 사태 심층 분석) (1) | 2025.11.30 |

| "커피는 번호로, 환자는 이름으로??? (0) | 2025.11.10 |