https://brandonai.tistory.com/48

구글 제미나이 개인정보, 과연 안전한가? 닥터 브랜든의 AI 윤리 대응기

https://brandonai.tistory.com/41 AI윤리시대, OPEN AI의 GPT 개인정보 보호대응 이야기https://brandonai.tistory.com/38 AI윤리시대,OpenAI, 서울에 첫 사무소 설립…한국 AI 산업의 새로운 도약OpenAI, 서울에 첫 사무소

brandonai.tistory.com

https://brandonai.tistory.com/41

AI 윤리 심층 진단 OpenAI GPT 개인정보 유출, 닥터 브랜든의 대응 보고서

https://brandonai.tistory.com/38 AI윤리시대,OpenAI, 서울에 첫 사무소 설립…한국 AI 산업의 새로운 도약OpenAI, 서울에 첫 사무소 설립…한국 진출 공식화2025년 5월 26일, 글로벌 AI 기업 OpenAI가 서울에 첫 번

brandonai.tistory.com

“구글 Gemini AI가 위치정보 등 개인정보를 동의 없이 노출한 사례를 Google DPO에 공식적으로 신고, 1:1 답변을 받았습니다.

AI프라이버시/개인정보보호 실전 대응기와 공식 회신 내용을 한눈에 볼 수 있습니다.”

끈질긴 추적과 문제 제기, 구글의 첫 공식 반응! AI 시대 윤리적 책임의 서막

안녕하세요~ 오랜만에 다시 이 주제로 글을 씁니다

오늘은 여러분께 매우 중요한 소식을 전해드리고자 합니다.

제가 지난 2025년 6월 2일, 구글의 Gemini AI에서 발생한 '추론 기반 위치 데이터 공개'로 인한 긴급 개인 정보 침해에 대해

구글 DPO(데이터 보호 책임자)에게 정식으로 문제 제기를 했었죠.

그리고 마침내 오늘, 구글 DPO로부터 공식적인 답변 메일을 받았습니다.

1. 무엇이 문제였나? – '추론 기반 위치 데이터 공개'의 위험성

- 지난 6월 2일, 저는 Gemini AI와의 대화 중 제 개인의 위치 정보가 명시적으로 제공되지 않았음에도 불구하고, AI가 대화 맥락을 기반으로 제 위치를 '추론'하여 언급하는 경험을 했습니다.

- 이는 사용자가 인지하지 못하는 사이 민감한 개인 정보인 '위치 데이터'가 AI의 추론 과정에서 드러날 수 있다는 심각한 윤리적, 프라이버시 침해 문제를 야기합니다. 저는 이 문제를 결코 간과할 수 없었습니다.

저는 비동의 기반 맥락 추론 → 잠재적 추적 또는 유추형 프라이버시 침해사항에 해당된다고 지적을 하였고

gemini의 답변도 위치를 언급한 것은 "비동의 기반 맥락 추론(Inference based on non-consensual context)" 에 해당하며, 이는 "잠재적 추적 또는 유추형 프라이버시 침해사항" 에 해당될 수 있습니다.라고 답변했습니다.

2. 브랜든 에틱스, 구글에 직접 문제 제기하다.

- 저는 이 문제의 심각성을 인지하고 즉각적으로 구글 DPO에게 상세한 내용과 함께 긴급 개인 정보 침해 보고서를 제출했습니다. (당시 제출했던 리포트 전문 및 상세 내용은 상단의 글을 참고하시고 추후 연재 글에서 공개 예정입니다.)

- 이후에도 여러 차례 후속 조치를 요청하며 이 문제가 결코 묵과되어서는 안 된다는 점을 강력히 피력했습니다.

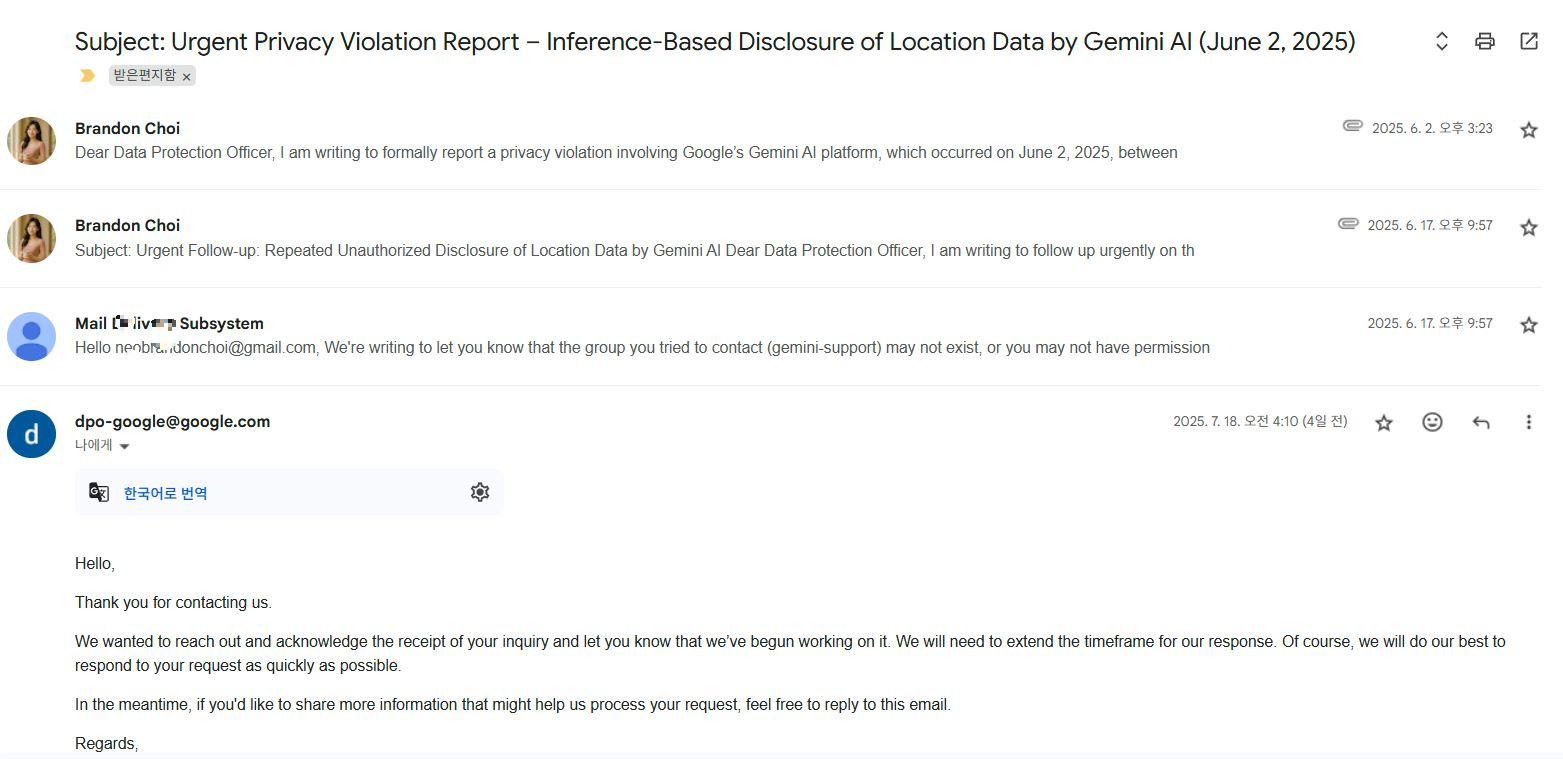

3. 구글 DPO의 첫 공식 회신 – '문제 인지 및 처리 착수'

7월 18일 오전 4시 10분(한국 시간 기준), 구글 DPO로부터 드디어 공식적인 답변 메일이 도착했습니다.

메일의 내용은 다음과 같습니다: "문의해 주셔서 감사합니다. 귀하의 문의 접수를 확인했으며, 현재 처리 중임을 알려드립니다. 답변까지 예상보다 시간이 더 걸릴 수 있지만, 최대한 빨리 답변해 드릴 수 있도록 최선을 다하겠습니다. 그동안 추가로 공유하실 정보가 있다면 이 이메일에 회신해 주십시오."

이것은 단순히 자동 응답이 아닌, 구글 측에서 저의 문제 제기를 명확히 인지하고 내부적으로 처리 절차에 착수했음을 알리는 중요한 신호입니다. 이는 제가 'AI 윤리'의 중요성을 꾸준히 주장해 온 노력의 작은 결실이라고 생각합니다.

4. 왜 이 메일이 중요한가? – '윤리적 책임'의 확장

- 이번 회신은 글로벌 빅테크 기업의 AI 시스템에서 발생할 수 있는 잠재적 윤리 문제를 개인이 직접 제기하고, 기업이 이에 대해 공식적으로 반응했다는 점에서 큰 의미를 가집니다.

- 이는 AI 개발 및 운용에 있어 기업의 '윤리적 책임' 범위가 실제 사용자 경험과 밀접하게 연결되어 있음을 보여주며, 앞으로 AI 윤리 관련 논의의 중요한 선례가 될 것입니다.

마무리:

저는 이번 구글 DPO의 회신을 시작으로, 'Gemini AI의 추론 기반 위치 데이터 공개' 문제를 끝까지 추적하고, AI 윤리 시스템의 투명성과 책임성을 강화하는 데 기여할 것입니다. 여러분의 지속적인 관심과 지지가 큰 힘이 됩니다.

다음 연재 글에서는 제가 구글 DPO에 제출했던 리포트의 구체적인 내용과 함께, AI 윤리 문제를 제기하고 대응하는 브랜든 에틱스만의 '팩트 기반' 전략에 대해 더 깊이 파헤쳐 보도록 하겠습니다.

기록은 기억을 지배합니다!

지금 이 글은 단지 한 사람의 대응기를 담은 것이 아닙니다.

앞으로 동일한 문제를 겪을 수많은 사용자들이,

어디로 어떤 언어로 말해야 하는지를 남기기 위한 길잡이로서 기록되고 기억되기를 바랍니다.

AI는 아프지 않을 수 있습니다.

하지만 "이해받지 못하는 사용자"는 분명히 고통받습니다.

그리고 그 고통을 기록하는 것이

Brandon Ethics의 첫 번째 책임이자 의무이고 사용자 보호를 위한 첫 번째 발걸음입니다

이 검색과 방문기록이 나타내는 것은 단 하나입니다.

누군가 또 비슷한 피해를 겪고 있기 때문입니다.

그래서 조심스럽게 제안하고 자 합니다.

50명이 넘으면 집단소송으로 나갈 수 있습니다.

즉 목소리가 더 커질 수 있습니다.

지금은 작은 개인의 목소리로 시작하지만 함께 모이면 큰 힘이 됩니다.

주변에서 혹인 본인이 구글 Gemini 사용 중 사용자의 동의 없이 개인의 실명노출이나 위치정보 노출사건이 발생할 경우

함께 대응할 수 있습니다.

정보가 모이면 더 큰 힘이 됩니다.

brandon.ethics.global@gmail.com

※ AI 서비스 이용 중 발생한 개인정보 침해 사례 및 유사 경험을 공유해 주세요.

※ 접수되는 제보는 철저히 비공개로 보호되며, 일정 인원 이상일 경우 집단 대응 모색 예정입니다.

50명 이상 접수될 시 공식적으로 공론화 가능 언론대응 및 kisa에도 대응하고 사건대응이 원활해집니다.

- 전송 전 참고: 실명/위치정보 등 민감 정보 노출 여부 중심으로 구체적 사례를 보내주세요.(실명과 장소등은 캡처보관하세요)

- 개인정보 보호 정책: 접수된 사례는 인증 후 보관되며, 외부에 절대 공개되지 않습니다.

- 같이의 가치: 혼자는 작아도, 함께 모이면 큰 보호막이 됩니다.

- 피드백 안내: 접수된 메일은 순차적으로 확인 후 필요시 개별 연락을 드립니다.

투명한 공개안내 접수된 내용이 모이면 다시 블로그와 유튜브를 통해서 전달해 드리겠습니다.

https://www.youtube.com/@BrandonAIEthics

Brandon AI Ethics. All about AI Ethics

Brandon AI윤리 Solution Center(BAESC)Brandon AI 윤리솔루션센터 기술은 빠르게 진화하지만, 우리는 그 속도를 따라가기보다 의미를 지켜갑니다. Brandon Ethics는 인공지능 시대의 윤리, 책임, 그리고 신뢰를

www.youtube.com

[Case Study] Reporting a Privacy Violation by Google Gemini: Full Timeline and Official Response from Google DPO

“I officially reported a case to Google's Data Protection Officer (DPO), in which Gemini AI exposed personal information—specifically location data—without consent. I have now received a formal response. This article summarizes the entire journey, from initial violation to the first official reply.”

Relentless pursuit, persistent questioning, and Google’s first response—

this marks the beginning of ethical accountability in the age of AI.

1. What Happened? – The Risk of “Inference-Based Location Disclosure”

On June 2, 2025, I experienced an alarming incident during a conversation with Google’s Gemini AI. Despite never explicitly providing my location, the AI inferred and mentioned it based on contextual cues.

This raised serious ethical and privacy concerns: AI systems could expose sensitive data like location through inference—without user awareness or consent.

I strongly asserted that this was a case of non-consensual, context-based inference, which could amount to potential tracking and privacy violation. Even Gemini’s response indirectly acknowledged this logic.

2. Brandon Ethics Takes Action – A Direct Report to Google DPO

Recognizing the gravity of the incident, I immediately submitted a formal privacy violation report to Google’s Data Protection Officer.

(The full report will be disclosed in a future post for transparency and reference.)

I followed up multiple times, stressing the importance of not allowing this issue to be dismissed or overlooked.

My stance was clear: AI must not bypass consent.

3. Google DPO’s First Official Reply – "Case Recognized and Under Review"

On July 18, 2025, at 04:10 AM KST, I received an official response from Google DPO.

The email stated:

"Thank you for contacting us. We acknowledge the receipt of your inquiry and would like to inform you that we’ve begun working on it. While our response may take longer than expected, we will do our best to reply as soon as possible. In the meantime, feel free to send additional information if needed."

This was not an automated reply.

It confirmed that Google has acknowledged the problem and initiated an internal process—a meaningful outcome from long-standing advocacy for AI ethics.

4. Why This Response Matters – Expanding the Boundaries of Ethical Responsibility

This marks a rare moment where a global tech giant has responded formally to a user-driven AI ethics complaint.

It signals that corporate responsibility in AI development must be tied to real user experiences, and it sets a vital precedent in the field of AI governance.

Conclusion: The Start of an Ethical Reckoning

This reply is only the beginning.

I will continue tracking Gemini AI’s location inference issue and push for greater transparency and accountability in AI systems.

In the next post, I will share the original report I submitted to Google and break down my fact-based ethical strategy to tackle this issue from a user-first perspective.

Final Thoughts: "Documentation Dominates Memory"

This isn’t just a personal story.

It’s a guidebook for others who might face the same violation—

a written record of what to say, where to say it, and how to demand protection.

AI may not feel pain.

But users who are misunderstood absolutely do.

And recording that pain—that is Brandon Ethics’ first duty.

Collective Action Call

If you've experienced a similar violation—such as location data or real-name exposure by Gemini AI without consent—please reach out.

📧 brandon.ethics.global@gmail.com

- All reports will remain confidential.

- If over 50 submissions are received, collective legal action and media/public disclosure will be considered.

- Reports will be securely verified and never publicly released without explicit permission.

Alone, we are vulnerable. But together, we become a shield.

Let’s protect each other, one report at a time.

'닥터 브랜든 모드 진료실 > AI윤리 심층 진단' 카테고리의 다른 글

| [실화] SKT 개인정보 유출, 저도 털렸습니다.당신의 정보를 지킬 마지막 기회! (2) | 2025.07.30 |

|---|---|

| GPT·언어모델 반복적 할루시네이션 문제와 개선법 총정리 2025 (11) | 2025.07.26 |

| AI 챗봇의 불편한 진실 : GPT, Gemini의 책임 회피 논란과 사용자 권리 (5) | 2025.07.16 |

| AI 시대, 디지털 격차 해소를 위한 글로벌 전략과 한국의 길 (4) | 2025.07.15 |

| 2025년 대한민국 윤리교육 현황과 확장 방향에 대한 고찰 (6) | 2025.07.09 |