안녕하세요~

오늘은 AI 시대의 핵심 도구인 GPT와 Gemini를 심층 분석하며, 이들이 과연 '책임 회피'라는 그림자 뒤에

숨어있는 것은 아닌지 진단해보려 합니다.

특히, "선택은 소비자, 책임은 나 몰라라"는 식의 태도가 과연 정당 한 지에 대해 깊이 있게 다뤄보겠습니다.

1. AI 상용화 1세대, 과연 몰랐을까?

ChatGPT가 등장한 지 어느덧 2년, 우리는 AI가 본격적으로 상용화되는 '1세대' 시대를 살아가고 있습니다. 불과 몇 년 전만 해도 상상하기 어려웠던 AI 기술이 이제는 우리의 일상 깊숙이 파고들어 다양한 형태로 활용되고 있죠.

하지만 이처럼 AI가 급속도로 확산되는 가운데, 우리는 AI 툴의 인터페이스 하단에서 다음과 같은 문구들을 심심찮게 발견합니다.

- ChatGPT: "ChatGPT는 실수를 할 수 있습니다. 중요한 정보는 재차 확인하세요."

- Gemini: "Gemini는 인물 등에 관한 정보 제공 시 실수를 할 수 있으니 다시 한번 확인하세요."

이 문구들을 보며 문득 의문이 듭니다.

과연 이 거대 AI 기업들은 자신들의 서비스가 이런 문제점을 안고 출시되었다는 것을 몰랐을까요?

아니면, 이미 알고 있었음에도 불구하고 특정 의도를 가지고 이러한 면책 조항을 명시한 것일까요?

놀랍게도, 이러한 문구는 한국의 유통 시장 구조, 특히 오픈마켓의 약관과 소름 끼치도록 유사합니다.

|

서비스 유형

|

면책 문구 예시

|

내포된 의미

|

|

AI 툴(GPT,GEMINI)

|

"실수할 수 있으니 재차 확인하세요."

|

AI 생성 정보의 오류 책임은 사용자에게 있음.

|

|

오픈마켓

(쿠팡,옥션,지마켓 11번가 등) |

"통신판매중개자이며 당사자가 아닙니다."

|

판매 상품의 문제 책임은 개별 판매자에게 있음.

|

- * ChatGPT는 실수를 할 수 있습니다. 중요한 정보는 재차 확인하세요.

- * Gemini는 인물 등에 관한 정보 제공 시 실수를 할 수 있으니 다시 한번 확인하세요.

이처럼 중요한 정보가 왜 하단에 '깨알 같은 글씨'로 표기되어 있을까요?

대부분의 사용자는 이를 자세히 읽지 않고 '그냥 그렇구나' 하고 넘어갑니다.

바로 이 지점에서 우리는 기업의 '무책임한 설계 구조'를 비판하고 경고해야 합니다.

제가 예전에 OPEN AI 개인정보 노출 연락을 위해 뒤지고 뒤져서 겨우 한국 에이전트를 찾은 사실이 있습니다.

꽁꽁 숨겨놓죠~

똑같습니다. 어느 기업이나 책임을 앞에 내세우지는 않습니다.

2. GPT (OpenAI) 심층 분석: 이상과 현실 사이의 책임

OpenAI의 ChatGPT는 전 세계적인 AI 열풍을 주도했습니다. 하지만 그 배경과 데이터 정책을 면밀히 살펴보면, 초기 이상과 현재의 현실 사이에서 '책임'이라는 중요한 가치가 어떻게 변화했는지 알 수 있습니다.

2.1 비영리에서 영리로, '오픈'에서 '비공개'로

- 초기 비영리 설립 (2015년): OpenAI는 '인류 전체에 이익이 되는 안전한 인공지능 개발'이라는 숭고한 목표 아래 비영리 연구 기관으로 출발했습니다. 이름처럼 AI 기술을 개방적으로 공유하겠다는 '오픈(Open)' 정신이 핵심이었습니다.

- 영리 부문 설립 및 MS 투자 (2019년 이후): AI 개발에 필요한 막대한 자금과 컴퓨팅 자원 확보의 어려움에 직면하며, OpenAI는 2019년 영리법인(capped-profit)을 설립하고 마이크로소프트(MS)로부터 수십억 달러의 대규모 투자를 유치했습니다. 이로써 MS는 OpenAI 기술을 자사 제품에 통합하며 긴밀한 협력 관계를 맺게 됩니다.

- '오픈' 소스에서 '비공개'로의 전환: 초기에는 연구 결과와 모델을 공개하는 '오픈' 기조였으나, GPT-3 이후부터는 핵심 모델이 비공개로 전환되었습니다. 이는 기술 경쟁 심화와 상업적 이익 추구라는 현실적인 이유 때문입니다. '오픈'이라는 이름이 무색해졌다는 비판이 나오는 지점입니다.

2.2 사용자 데이터, 과연 안전한가? - '지브리 열풍'의 이면

ChatGPT와 같은 대규모 언어 모델(LLM)은 인터넷상의 방대한 데이터를 학습합니다.

이 과정에서 개인정보나 저작권이 있는 데이터가 포함될 수 있다는 논란은 끊이지 않고 있습니다.

더 큰 문제는 사용자 입력 데이터의 활용입니다.

OpenAI는 기본적으로 사용자 대화 데이터를 모델 개선 및 학습에 활용할 수 있다고 명시합니다.

사용자가 명시적으로 '데이터 학습에 사용하지 않음' 옵션을 설정하지 않는 한,

우리가 입력하는 모든 정보가 AI 모델의 '지식'으로 흡수될 수 있다는 의미입니다.

'지브리 열풍'과 같은 사례를 떠올려 봅시다.

수많은 사용자가 특정 스타일의 이미지를 생성하기 위해 프롬프트와 이미지를 입력합니다.

과연 이 수많은 전 세계 사용자들의 창작물과 입력된 정보들이 안전하게 보관되고 처리되고 있을까요?

명확한 동의와 투명한 데이터 처리 과정이 필수적입니다.

2.3 "실수할 수 있습니다. 재차 확인하세요" - 책임 전가의 시작

이 문구는 AI의 '환각(Hallucination)' 현상, 즉 사실과 다른 정보를 마치 사실처럼 생성할 수 있는 본질적인 한계를 사용자에게 고지하는 것입니다. 하지만 이는 동시에 AI가 생성한 정보의 최종 검증 책임은 AI 제공자가 아닌 사용자에게 있다는 입장을 명확히 하는 것입니다.

물론 GPT의 구조적 한계도 명확히 존재합니다. GPT는 즉 추론을 하도록 설계됐기 때문입니다.

3. Gemini (Google) 심층 분석: 변화 속의 불확실성

Google의 Gemini 역시 AI 시대의 주요 플레이어로서, 그 변화 과정과 데이터 정책을 살펴볼 필요가 있습니다.

3.1 Bard에서 Gemini로의 진화

Google은 ChatGPT의 등장에 대응하여 'Bard'라는 대화형 AI를 급하게 선보였습니다. 이후 Google은 자사의 가장 강력한 차세대 AI 모델인 'Gemini'를 개발하고, Bard를 Gemini 모델 기반으로 전환하며 이름을 'Gemini'로 변경했습니다. 이는 Google의 모든 AI 역량을 'Gemini'라는 단일 브랜드로 통합하고, 텍스트뿐만 아니라 이미지, 오디오, 비디오 등 다양한 형태의 정보를 이해하고 생성하는 '멀티모달' 기능을 강화하겠다는 전략적 결정이었습니다.

3.2 정보 공개와 책임의 모호성

Gemini 역시 사용자 대화 데이터를 모델 개선에 활용할 수 있다고 명시하고 있습니다. 사용자는 활동 제어 설정에서 'Gemini 활동'을 끄거나 특정 활동을 삭제할 수 있지만, 기본 설정은 데이터가 활용될 수 있는 방향으로 되어 있습니다.

- "인물 등에 관한 정보 제공 시 실수를 할 수 있으니 다시 한번 확인하세요." 이 문구는 특히 '인물'과 같이 민감하고 사실 확인이 중요한 정보에 대한 AI의 오류 가능성을 명확히 합니다. 이는 AI가 생성하는 정보의 중요도에 따라 책임의 무게가 달라질 수 있음을 시사하기도 합니다. Google은 Gemini의 '사실성'과 '신뢰성'을 강조하지만, 여전히 환각 현상이나 편향된 답변이 발생할 수 있다는 한계를 가지고 있습니다.

4. 닥터브랜든모드 경고 : '선택은 소비자, 책임은 나 몰라라'는 없다

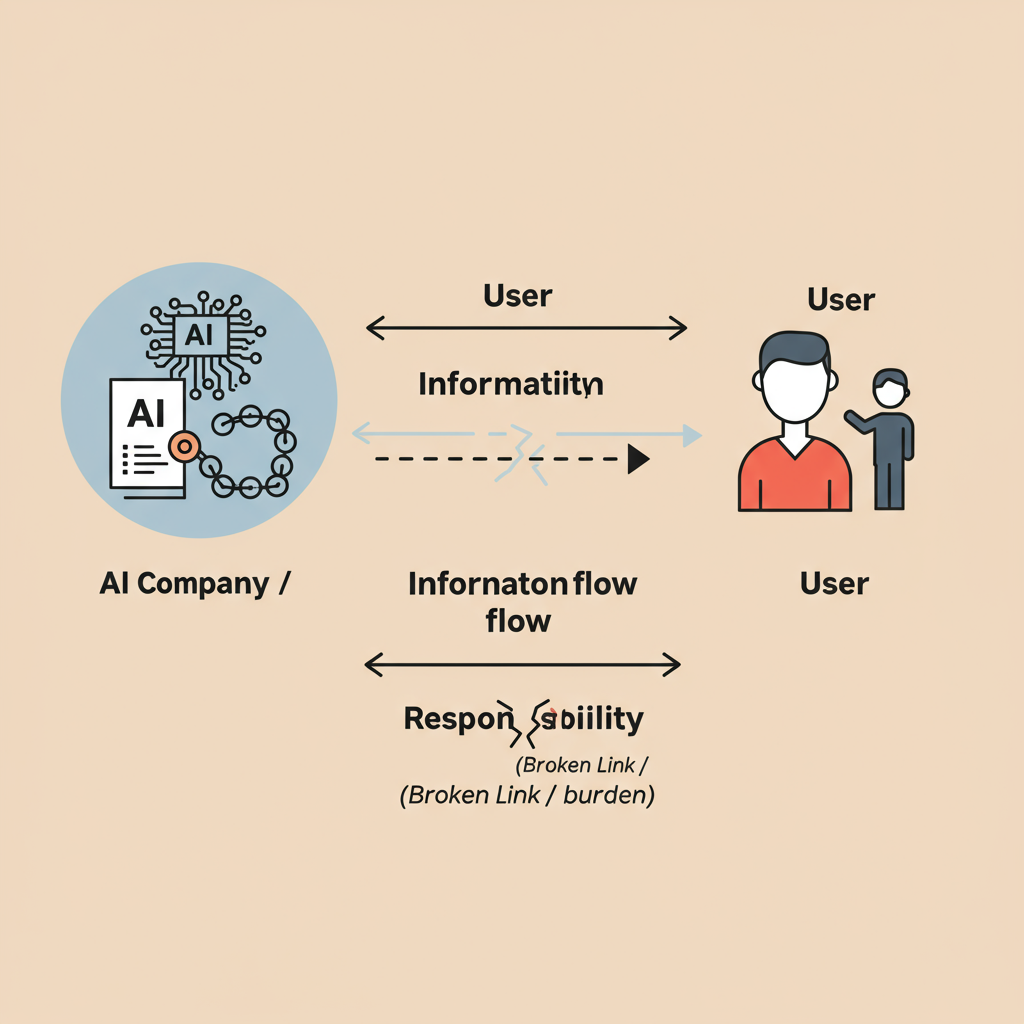

AI 툴(GPT, Gemini)과 오픈마켓에서 공통적으로 나타나는 이러한 '면책 조항'은 플랫폼의 책임 범위를 최소화하려는 전략으로 해석될 수 있습니다.

이는 정보의 비대칭성을 악용하는 기업의 행태이자, 막대한 이익과 영향력에 상응하는 사회적 책임을 회피하려는 시도입니다.

AI가 생성하는 정보는 단순한 상품을 넘어 우리의 지식, 판단, 심지어 가치관에까지 영향을 미칠 수 있습니다. 잘못된 정보나 편향된 판단이 개인의 삶뿐만 아니라 사회 전체에 미칠 수 있는 파급력은 오픈마켓의 상품 하자와는 비교할 수 없을 정도로 큽니다.

따라서, AI 개발사와 서비스 제공자들은 단순히 "실수할 수 있으니 확인하라"는 문구 뒤에 숨을 것이 아니라, 자신들이 제공하는 서비스로 인해 발생할 수 있는 문제에 대해 막중한 사회적 책임을 져야 합니다.

'고지했다'는 이유만으로 모든 책임에서 벗어날 수는 없습니다.

다음 2차 특집에서는 '유통 플랫폼'의 책임 회피 구조에 대해 더욱 심층적으로 다뤄보겠습니다.

실제 근무경험을 바탕으로, 현장의 실상을 생생하게 전달하며 정보의 비대칭성이 소비자 피해로 이어지는 과정을 파헤쳐 볼 예정이니 많은 기대 부탁드립니다.

https://www.youtube.com/@BrandonAIEthics

Brandon AI Ethics

Brandon AI윤리 Solution Center(BAESC)Brandon AI 윤리솔루션센터 기술은 빠르게 진화하지만, 우리는 그 속도를 따라가기보다 의미를 지켜갑니다. Brandon Ethics는 인공지능 시대의 윤리, 책임, 그리고 신뢰를

www.youtube.com

Hello,

Today, we take a deep dive into two of the most influential AI tools of our time—GPT and Gemini—to critically assess whether these technologies are, in fact, operating under the shadow of “responsibility evasion.”

In particular, we will examine the ethics behind the notion that “the choice is yours, but responsibility is not ours.”

1. The First Generation of Commercial AI – Were They Truly Unaware?

It has now been over two years since the launch of ChatGPT. We are currently living in the first era of widespread AI commercialization, where technology that once seemed futuristic is now deeply embedded in our daily lives.

However, alongside this rapid expansion, we often encounter certain disclaimers at the bottom of AI tool interfaces:

- ChatGPT: “ChatGPT may make mistakes. Please verify important information.”

- Gemini: “Gemini may make mistakes when providing information about people. Please double-check.”

These statements raise a serious question:

Did these major AI companies really not know their services had such limitations upon release?

Or were these disclaimers intentionally crafted as a strategic shield?

Surprisingly, these phrases bear an uncanny resemblance to the terms and conditions used in South Korean open marketplaces, such as Coupang, Auction, Gmarket, and 11st.

| AI Tools (GPT, Gemini) | “Please verify again, as errors may occur.” | Responsibility for errors is shifted to the user. |

| Open Markets (e.g., Coupang, Auction, Gmarket) | “We are an intermediary, not the seller.” | Responsibility for product issues is on the individual vendor. |

Why are such critical statements buried at the bottom of interfaces in tiny fonts?

Most users skip over them without much thought.

This is where we must raise a red flag about the irresponsible architecture behind these platforms.

I once had to dig through layers of information just to find OpenAI’s Korean legal agent regarding a data privacy issue.

They hide it well—like many companies, they never lead with accountability.

2. GPT (OpenAI) Deep Analysis: Between Idealism and Reality

ChatGPT has spearheaded the global AI revolution.

Yet when examining its founding vision versus its current data policies, we find a clear shift in the way “responsibility” has evolved.

2.1 From Non-Profit to For-Profit, From ‘Open’ to ‘Closed’

- Initial Launch (2015): OpenAI began as a non-profit with the noble goal of developing safe and beneficial AI for all humanity. True to its name, it promoted openness in AI development and research.

- 2019 and Beyond: Facing resource limitations, OpenAI created a for-profit arm and secured billions in investment from Microsoft, who then began integrating OpenAI’s technology into its own products.

- Post-GPT-3: The company shifted from publishing open-source models to withholding key technical details—a move driven by commercial competition and profit motives.

The result? The name “OpenAI” no longer reflects its operating reality.

2.2 Is User Data Truly Safe? – Behind the “Ghibli Craze”

Large language models like ChatGPT are trained on vast datasets, many of which originate from the public web.

This has triggered ongoing controversy over the inclusion of personal information and copyrighted materials.

The greater concern lies in how user input data is handled.

By default, OpenAI reserves the right to use your input for training and product improvement unless you manually opt out.

This means unless users explicitly change their settings, every word they type may be absorbed into the model’s collective “knowledge.”

Think of the “Ghibli-style image” trend, where millions submitted prompts and uploads to generate similar artwork.

Were those inputs stored securely? Were they used as training data?

Without clear consent and transparent data practices, trust cannot be earned.

2.3 “This AI May Make Mistakes” – The Beginning of Blame Shifting

Such disclaimers are designed to address AI hallucination—the phenomenon where AI confidently generates false or misleading information.

But let’s be clear:

While the tool’s limitations are acknowledged, the burden of verification and consequences still lies with the user.

Even though GPT operates as a probabilistic inference engine, the responsibility for its errors is outsourced to individuals.

3. Gemini (Google) Deep Analysis: Uncertainty in Transition

Gemini, Google’s flagship AI model, deserves its own critical review.

3.1 From Bard to Gemini

Initially released in a rush to counter ChatGPT, Google’s Bard was soon rebranded as Gemini, incorporating the company’s full suite of AI technologies.

Gemini now aims to be a multimodal powerhouse, handling not just text, but images, audio, and video.

3.2 Ambiguity in Data and Accountability

Like OpenAI, Gemini uses user conversations to improve its models, unless the user explicitly disables this in activity settings.

The disclaimer—

“Gemini may make mistakes when providing information about people”—

particularly emphasizes the risks of hallucinations when handling sensitive or factual content.

Despite claims of accuracy, Gemini still exhibits biases and factual errors.

The responsibility for these limitations, once again, rests with the user.

4. Dr. Brandon’s Ethical Warning:

“You Can’t Say: ‘You Choose, We’re Not Responsible.’”

Both AI tools (GPT, Gemini) and platforms like open markets adopt similar liability disclaimers, shifting accountability away from themselves.

This reveals a common strategy:

To exploit information asymmetry while enjoying massive influence and profit, without corresponding social responsibility.

AI-generated content is not just a product—it shapes our decisions, beliefs, and value systems.

The social cost of misinformation and bias far exceeds defective goods on open markets.

Thus, developers and service providers must take full responsibility for the potential harm their services may cause.

The phrase “We warned you, so it’s not our fault” is not a valid ethical position.

Coming Soon:

Part 2 – The Hidden Responsibility Structures of Digital Distribution Platforms

With real-world experience and field insight, we will further expose how platform structures and algorithms create consumer harm through structural opacity.

Please stay tuned.

#AI챗봇 #GPT #Gemini #AI책임 #책임회피 #AI윤리 #개인정보보호 #환각현상 #사용자권리 #심층진단

'닥터 브랜든 모드 진료실 > AI윤리 심층 진단' 카테고리의 다른 글

| GPT·언어모델 반복적 할루시네이션 문제와 개선법 총정리 2025 (11) | 2025.07.26 |

|---|---|

| [실전 사례] 구글 제미나이 개인정보 침해 신고기: Google DPO 공식 답변 및 전 과정 총정리 (5) | 2025.07.22 |

| AI 시대, 디지털 격차 해소를 위한 글로벌 전략과 한국의 길 (4) | 2025.07.15 |

| 2025년 대한민국 윤리교육 현황과 확장 방향에 대한 고찰 (6) | 2025.07.09 |

| OPEN AI의 뻔뻔한 AI사용자 계급화와 해명, 신뢰는 환불되지 않는다 -"AI Refund Disaster" (4) | 2025.07.06 |