Brandon Times 11월 첫째 주 AI 뉴스 요약

ChatGPT 보안 취약점·Google Gemini 프라이버시 논란·연세대 AI 부정행위·Perplexity 데이터 유출

1. ChatGPT, 11월 5일 ‘7개 주요 취약점’ 발견

2025년 11월 5일, OpenAI의 ChatGPT에서 7개의 심각한 보안 취약점이 발견되었다는 소식이 전해졌습니다.

2023년 3월 대규모 데이터 유출 사건 이후 또다시 발생한 이번 문제는,

AI 모델의 보안 구조가 여전히 완전하지 않음을 보여줍니다.

AI 서비스 확산 속도에 비해 ‘보안윤리’의 진화가 더디다는 경고이기도 합니다.

2. Google Gemini, 사용자 데이터 수집 논란

Google이 자사 AI 모델 ‘Gemini’를 통해

사용자의 음성, 위치, 스크린 콘텐츠까지 수집하며 이 데이터를 제3자 분석업체가 직접 열람·분석한다는 사실이 드러났습니다.

이에 구글은 공식적으로 “기밀 정보를 입력하지 말라”는 경고를 내렸습니다.

AI 기술의 편리함 이면에 자리한 프라이버시 침해 문제가 다시 한 번 부각되었습니다.

3. 연세대학교, AI 이용 집단 부정행위 적발

‘자연어 처리와 챗GPT’ 강의에서 약 600명 중 190명이 AI 도구를 사용해 중간고사 부정행위를 한 사실이 밝혀졌습니다.

교수는 해당 학생들에게 0점 처리를 통보하며 AI 일상화 시대의 비판적 사고력 저하와 교육 방식 재검토 필요성을 지적했습니다.

교육현장에서도 이제 ‘AI 윤리 리터러시’가 중요한 과제로 떠오르고 있습니다.

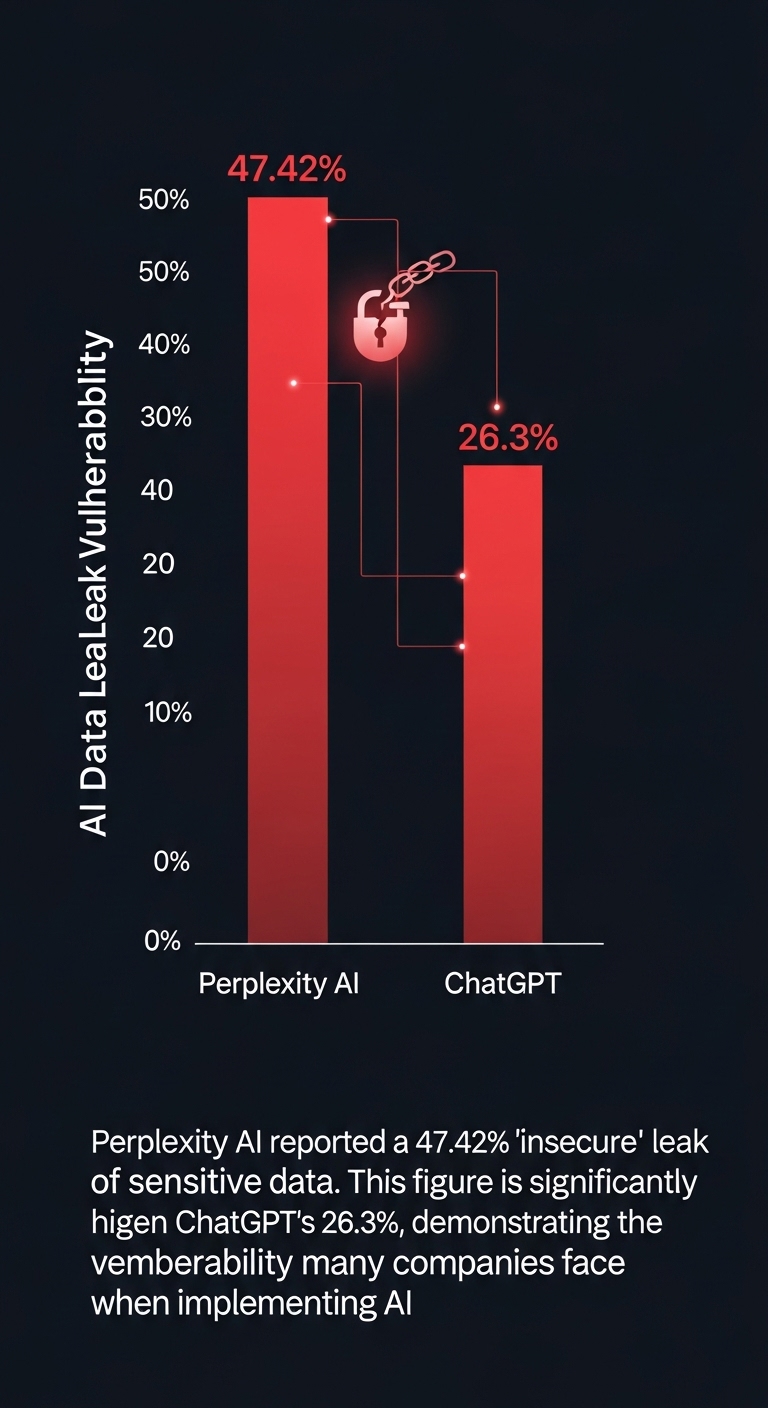

4. Perplexity, 민감 데이터 47.42% ‘비보안 유출’

AI 검색엔진 Perplexity가 사용자 민감 데이터의 47.42%를 비보안 환경에서 유출하고 있었다는 분석 결과가 공개되었습니다.

이는 ChatGPT(26.3%)보다 훨씬 높은 수치로, AI 기업들의 데이터 보호 책임이 얼마나 취약한지 보여줍니다.

“AI 신뢰”는 결국 데이터 윤리와 투명성 위에서만 유지될 수 있음을 시사합니다.

Brandon Times 결론

AI 기술의 발전 속도는 멈추지 않지만,

그 속에서 윤리·보안·신뢰는 반드시 함께 성장해야 합니다.

이번 주 AI 뉴스는 우리에게 묻습니다.

“우리는 기술을 얼마나 신중하게 다루고 있는가?”

다음 주에도 Brandon Times는 AI 시대의 흐름을 윤리적 시선으로 전해드리겠습니다.

#AI뉴스 #AI윤리 #ChatGPT보안 #GoogleGemini #연세대학교부정행위 #Perplexity데이터유출 #AI윤리솔루션센터 #BrandonTimes #AI리터러시

#AInews #AIethics #ChatGPTsecurity #GoogleGeminiPrivacy #YonseiUniversity #PerplexityLeak #AIliteracy #BrandonTimes #AIEthicalSolutions

Brandon Times: AI News Roundup (First Week of Nov 2025)

ChatGPT Vulnerabilities, Google Gemini Privacy Scandal, Yonsei AI Cheating, & Perplexity Data Leak

1. ChatGPT Rocked by '7 Critical Vulnerabilities' (Nov 5)

On November 5, 2025, shocking news broke: 7 critical security vulnerabilities were discovered in OpenAI's ChatGPT. This incident, following the massive March 2023 data leak, demonstrates that AI models' security architecture is still far from perfect. It serves as a stark warning that the evolution of 'security ethics' is lagging far behind the speed of AI adoption.

2. Google Gemini's User Data Collection Scandal

It was revealed that Google's AI model, 'Gemini', collects user voice, location, and even screen content, and that this data is being reviewed and analyzed by third-party contractors. Google has even officially warned users, "Do not input confidential information." This once again highlights the severe privacy infringement issues lurking behind the convenience of AI technology.

3. Yonsei University Exposes Mass AI-Driven Cheating

In a 'Natural Language Processing and ChatGPT' course, it was discovered that 190 out of 600 students used AI tools to cheat on their midterm exam. The professor announced a 0-point score for those students, highlighting the decline in critical thinking in the age of AI and the need to overhaul educational methods. This incident proves that 'AI Ethics Literacy' has become a crucial challenge in the educational field.

4. Perplexity Leaks 47.42% of Sensitive Data (Non-Secure)

An analysis revealed that the AI search engine Perplexity was leaking 47.42% of user sensitive data in non-secure environments. This rate is significantly higher than ChatGPT's (26.3%) and exposes just how weak the data protection accountability is for many AI companies. This implies that "AI Trust" can only be sustained on a foundation of data ethics and transparency.

Brandon Times Conclusion

The pace of AI development will not stop, but ethics, security, and trust must grow alongside it. This week's AI news poses a critical question to us all:

"How carefully are we truly handling this technology?"

Brandon Times will return next week, delivering insights on the AI era through an ethical lens.

'우리들의 AI 윤리 이야기 > Brandon Times' 카테고리의 다른 글

| 속도·기억·영상 전쟁 GPT‑5.1, 제미나이 3.0, 그록 이매진으로 본 11월 AI 판도 Brandon Times 11월2주차 주간AI뉴스 요약 (0) | 2025.11.17 |

|---|---|

| [충격 반전] AI 시대 토끼와 거북이 (둘 다 패배했습니다) AI STRIKE EP27 (0) | 2025.11.13 |

| 아기돼지 삼형제와 해커 늑대의 보안 이야기! AI STRIKE 시즌2 EP26 (0) | 2025.11.07 |

| "GPU 26만장, 저널리즘 자동화, AI 노동 대체...한국은 어디로 가나?" (0) | 2025.11.03 |

| Brandon Times 주간AI 뉴스 요약 K-AI 윤리 경보: 카카오, OpenAI의 성인 콘텐츠 정책 논란에 직면하다 (0) | 2025.10.27 |